EMNLP2016読み会@黒橋研

- 1. EMNLP2016読み会@⿊橋研 佐藤 元紀|Motoki Sato NAIST 松本研 (M1) 1. Deep Multi-Task Learning with Shared Memory 2. How Transferable are Neural Networks in NLP Applications?

- 2. 名前 佐藤 元紀 (さとう もとき) 所属 NAIST (松本研) 学年 修⼠1年⽣ Twitter @aonotas あおのたす ⾃⼰紹介 2 研究の興味 QA, 対話, 深層学習 Chainer派閥

- 3. 紹介する論⽂①

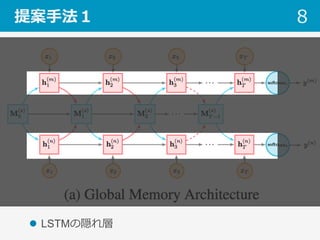

- 4. 紹介する論⽂① l Deep Multi-Task Learning with Shared Memory – LSTMに外部メモリを追加し, Multi-Taskを解く – ⽂書分類タスク(同じドメインの複数データセット) • Movie Review – タスクで共通のメモリ, タスクごとのメモリを⽤意 4

- 5. Motivation l Neural Networkは過学習しやすい – Pre-trainingが使われるが, 直接タスクを最適化しているわけではない – Multiタスクで共通知識を共有して性能を向上させたい l LSTMの外にメモリを付けて表現⼒向上を狙う 5

- 6. 提案⼿法1 6

- 11. ここの部分を詳しく! 11

- 14. モデルの詳細 14 l Reading key vector l Erase vector l Add vector

- 15. モデルの詳細 15 l Read l Write l Fusion

- 16. 提案⼿法2 16

- 17. 実験結果 17

- 18. 実例 18

- 19. 紹介する論⽂②

- 20. 紹介する論⽂② l How Transferable are Neural Networks in NLP Applications? – NLPにおける転移学習の論⽂ – 画像のNN分野での転移学習との⽐較 – 結論が分かりやすい(予想通りっちゃ予想通り) 20

- 21. 問題設定 21 学習 データ 多 学習データ 少 Source Target Train NN Transfer

- 22. 転移学習アルゴリズム l INIT – ⼤きいデータで学習し, NNのパラメータを初期値とする (Fine-tune) l MULTI – 同時に⼤きいデータと⼩さいデータで学習する l MULTI+INUT – ⼤きいデータで学習し, その後マルチタスクで解く 22

- 23. 画像 vs NLP l 画像 – 連続値 – 素性がピクセル単位 l NLP – 離散的 23

- 26. ネットワーク構造 26

- 28. 実験結果 28 パラメータ固定 l ドメイン似ている – Embedding, hiddenはTransfer l ドメインが異なる – EmbeddingだけTransfer

- 29. 実験結果 29 パラメータ固定 l ドメイン似ている – Embedding, hiddenはTransfer l ドメインが異なる – EmbeddingだけTransfer

- 31. MULTI 31 ■ドメイン似ているタスク – Source重視の⽅が良い ■ドメインが異なるタスク – MULTIでもダメ INIT Non- transfer