[輪読会]Multilingual Image Description with Neural Sequence Models

- 2. 書誌情報 • Title: MULTILINGUAL IMAGE DESCRIPTION WITH NEURAL SEQUENCE MODELS • Author: Desmond Ellio6, Stella Frank, Eva Hasler • AffiliaTon: University of Amsterdam, Cambridge • URL: h6p://arxiv.org/abs/1510.04709 • ICLR’16 不採録 • 概要 : MulTlingual Image DescripTon – ある画像に対して言語Aのキャプションを生成するとき,言語Bの情報も使う

- 3. MoTvaTon • 関連研究 : キャプション生成 – 入力画像に対して,その画像の説明文を生成する – 画像とその画像に対するキャプションのデータを利用して学習 • この論文の主題 – ある画像に対して,言語Bでキャプションを生成するとき,言語Aでのキャプションを生か すことができるか? – MulTlingual Image DescripTon

- 4. Approach • MulTlingual mulTmodal language model • ターゲットのキャプションを生成するのに,以下の2つの特徴量を使う – monolingual source-language image descripTon model – visual features from an object recogniTon model

- 5. モデル : Recurrent Language Model (LM) • RNNである単語を入力したとき,次の単語を予測するように訓練 – 入力 w_i (あるステップiにおいて)

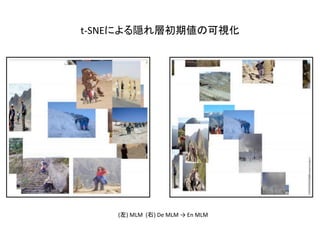

- 6. モデル : MulTmodal Language Model (MLM) • 画像の情報をLMに組み込む – 画像特徴量で条件付ければ良い – 一つの方法 : h_0 の計算をする際に画像特徴量を入れる • 各タイムステップで画像特徴量を入れると, overfidng するという研究報告が複数ある

- 9. NMT (Neural Machine TranslaTon) モデルとの違い • NMT – (翻訳元言語, 翻訳先言語) のペアで学習 • このモデル – データセットの扱いがより柔軟 (言語のペアを用意しなくても良い) – source-language modelとtarget-language modelは別々のものでも良い • e.g. sequense-to-sequense, encoder-decode, …

- 10. 実験 : 使用したデータ • データ : IAPR-TC12 – 画像数 : 20000 – 英語のキャプションと,対応するドイツ語訳 – 17,665枚を訓練に利用 – 英語 : 272,172 トークン (語彙数 1763) (出現頻度3以下は除去) – ドイツ語: 223,147 トークン (語彙数2374) – 画像特徴量はVGG-16を利用して抽出

- 15. まとめ • 画像キャプショニングをする際に,別の言語のキャプションを利用する方 法の提案 • マルチモーダルな翻訳の一つ • 単純に画像と言語を組み合わせるだけだと,なかなかスコアが上がらな い • (ドイツ語のキャプション生成の実施) – 英語より難しい

- 17. ACL’16でのMulTmodal Machine TranslaTon • h6p://www.statmt.org/wmt16/mulTmodal-task.html • 今回の著者らがオーガナイザー • データセット: flickr30k – 英語のキャプションと,それに対応するドイツ語訳 • タスク 1. MulTmodal Machine TranslaTon 2. Mulilingual Image DescripTon • 結論を言うと,あんまり良いのは無かった

- 20. 優勝チームの手法

![[輪読会]Multilingual Image Description with Neural Sequence Models](https://image.slidesharecdn.com/misono-160912132118/85/Multilingual-Image-Description-with-Neural-Sequence-Models-12-320.jpg)

![[輪読会]Multilingual Image Description with Neural Sequence Models](https://image.slidesharecdn.com/misono-160912132118/85/Multilingual-Image-Description-with-Neural-Sequence-Models-16-320.jpg)