スタートアップが提案する2030年の材料開発 - 2022/11/11 QPARC講演

- 2. 2 計算機の発展

- 3. 3 ● “2030年の材料開発”に向けて ○ 長期的な目線ではどういう研究が活きるか ○ コンピュータサイエンスの事例から 長期的に価値の出る研究方針

- 4. 4 ● “The Bitter Lesson” (苦い教訓) http://www.incompleteideas.net/IncIdeas/BitterLesson.html ○ 強化学習の創始者 Richard Sutton の投稿 ○ 長期的に見ると、 “人間のドメイン知識を利用したアプローチ” よりも “シンプルで汎用的な方法を用いて計算力に頼る” 方法が効果的であった。 ○ 例1:チェス ○ 例2:画像認識 長期的に価値の出る研究方針 既存研究 人間の理解やチェス独自の構造を取 り入れたアルゴリズム Deep Blue 膨大な探索 1997 World Championに勝利 既存研究 edge, cylinder, SHIFTといった特徴量 の抽出を人手で設計 Covolutional Neural Network (CNN) シンプルな計算の層を積み重ね、 計算力に頼って、自動で特徴抽出を 学習 2012 画像認識コンペでスコア大幅更新

- 5. 5 ● “The Bitter Lesson” (苦い教訓) http://www.incompleteideas.net/IncIdeas/BitterLesson.html ○ まとめ ○ One thing that should be learned from the bitter lesson is the great power of general purpose methods, of methods that continue to scale with increased computation even as the available computation becomes very great. The two methods that seem to scale arbitrarily in this way are search and learning. ○ ○ 10年くらいの長いスパンで見てみると、汎用的な手法を用いて 計算能力の向上の恩恵を直接受けられるメリットが大きくなる。 ○ 特に探索と学習はどこまでもスケールする。 長期的に価値の出る研究方針

- 6. 6 Mooreの法則 ● 1年半〜2年ごとに計算力は2倍に ● 1965年に論文が発表されて以降、 いつかは頭打ちになると言われつつも 今でも指数関数的によくなるという トレンドは続いている。 概算すると、もしこのペースが続くなら ● 8年後、2030年に計算力は16倍に 計算機の進化 From https://en.wikipedia.org/wiki/File:Moore%27s_Law_Transistor_Count_1970-2020.png by Hannah Ritchie and Max Roser under CC-BY 4.0

- 7. 7 ● PFNは将来の計算力向上を見据えた研究開発のため、自社で計算資源を保有 ○ https://www.preferred.jp/ja/news/tag/cluster/ PFNで保有する自社クラスター クラスター 主な計算資源 MN-1 (運用終了) [GPU] P100 x 8: 128台 MN-1b (運用終了) [GPU] V100 x 8: 64台 MN-2a [GPU] V100 x 8: 128台 [CPU] Xeon 36 core: 32台 MN-2b [GPU] A100 x 6: 42台 [GPU] A30 x 6: 42台 MN-3a [MN-core] MN-core x 4: 48台

- 10. 10 ● 2012年、画像認識コンペILSVRCでAlexNetの登場 (GPUを有効活用した) ● 以降GPUの発展とともに、年々ネットワークが深く、巨大になっていった Neural Networkの大規模化 年 CNN 深さ Parameter数 2012 AlexNet 8層 62.0M 2014 GoogleNet 22層 6.4M 2015 ResNet 110層 (Max1202層!) 60.3M https://towardsdatascience.com/the-w3h-of-alexnet-vggnet-resnet-and-inception-7baaaecccc96 GoogleNet “Going deeper with convolutions”: https://arxiv.org/pdf/1409.4842.pdf ResNet “Deep Residual Learning for Image Recognition”: https://arxiv.org/pdf/1512.03385.pdf

- 11. 11 ● 画像分野のデータセット量 ● 指数関数的にデータセット規模も大きくなり、 人間1人では扱えない、全体の集合知を学習するように。。。 ● 事前学習→特定タスク用にFine tuningする流れ データ量増加のトレンド データセット名 データ数 クラス数 MNIST 6万枚 10 CIFAR-100 6万枚 100 ImageNet 130万枚 1,000 ImageNet-21k 1400万枚 21,000 JFT-300M, 3B, 4B 3億, 30億, 40億枚 (Google非公開) 18,000〜

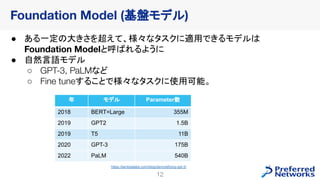

- 12. 12 ● ある一定の大きさを超えて、様々なタスクに適用できるモデルは Foundation Modelと呼ばれるように ● 自然言語モデル ○ GPT-3, PaLMなど ○ Fine tuneすることで様々なタスクに使用可能。 Foundation Model (基盤モデル) 年 モデル Parameter数 2018 BERT=Large 355M 2019 GPT2 1.5B 2019 T5 11B 2020 GPT-3 175B 2022 PaLM 540B https://lambdalabs.com/blog/demystifying-gpt-3/

- 13. 13 ● 推論モデルをどう使いこなすか? ○ 入力を工夫することで異なるアプリケーション・様々な用途に使用可能 ○ “Prompt Engineering” ■ ノウハウが必要になり、 プロンプトエンジニアといった職種が仕事になってきている Foundation Model (基盤モデル) 言語翻訳タスクのpromptの例 https://arxiv.org/abs/2108.07258 Exampleを提示することで精度 が上がる。

- 14. 14 ● 画像生成 ○ DALL-E2, Imagen, Midjourney, Stable Diffusion ○ 汎用的に使える。いろいろなタスクに使える。 ● “a gentleman otter in a 19th century portrait” by Stable Diffusion Foundation Model (基盤モデル) https://replicate.com/api/models/stability-ai/stable-diffusion/fi les/8d6a8069-b91f-4e61-8136-fa7c0775532c/out-0.png

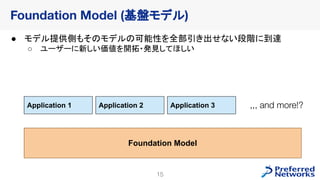

- 15. 15 ● モデル提供側もそのモデルの可能性を全部引き出せない段階に到達 ○ ユーザーに新しい価値を開拓・発見してほしい Foundation Model (基盤モデル) Foundation Model Application 1 Application 2 Application 3 ,,, and more!?

- 16. 16 Matlantis

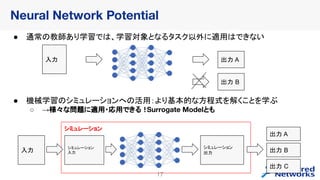

- 17. 17 Neural Network Potential ● 通常の教師あり学習では、学習対象となるタスク以外に適用はできない 入力 出力 A 入力 シミュレーション 出力 ● 機械学習のシミュレーションへの活用:より基本的な方程式を解くことを学ぶ ○ →様々な問題に適用・応用できる! Surrogate Modelとも 出力 A 出力 B 出力 C シミュレーション 入力 出力 B シミュレーション

- 18. 18 ● 汎用原子レベルシミュレーター ○ 汎用: 72元素で構成される系のシミュレーションが可能 (※PFP v3) ○ 高速: 従来の量子化学計算と比較して、圧倒的に高速 ● Preferred NetworksとENEOSで研究開発、Preferred Computational Chemistry から販売 Matlantis

- 19. 19 ● データ収集 ○ 製品版(PFP v3.0)では1,144GPU 年分の計算資源使用 ○ 様々な用途に適用できるよう、多種多様なデータを、大量に獲得 Matlantis MN-Clusterを活用しデータ収集 bulk crystal amorphous surface surface + mol. cluster molecule

- 20. 20 ● PFPの可能性はモデル提供側も未知数 ○ モデルの活用方法次第で、様々な“知識”が取り出せることを期待 ○ 「ノーベル賞を取る人が出てほしい」 Matlantis PFP Structural Relaxation Reaction Analysis Molecular Dynamics ,,, and more!!

- 21. 21 ● NNP自体へのメリット ○ 精度を重視 ○ 速度や取り扱える原子数は計算機の発展でも解消していく ● 原子数スケール・シミュレーション時間 ○ 計算機の性能が数十倍になる頃には、、、 ○ 扱える原子数:数千原子 → 数十万原子オーダー ○ MD時間 :1 ps → 数十 ps ○ 構造最適化数:1000万構造 → 数十億構造のOptimization ○ この変化で、どういう問題が解けるようになるか?? 計算機のスケールによるMatlantisへのメリット

- 22. 22 ● https://matterverse.ai/ ○ 計算機の発展を生かした大規模探索例 ○ NNPを使うことで、3179万構造に対して計算を実行し、データベース化 周辺動向: Matterverse https://matterverse.ai/details/mv-31324330

- 23. 23 ● “Bitter lesson”を振り返り、、将来に活きるソフト資産は ● 今からユーザー側でHigh throughput screeningのノウハウを貯めておくこと で、計算機の向上の恩恵を受けられる。 ● 汎用的に使えるモデル、多種多様な材料に適用しデータベースを構築できる。 ● データベースを学習し、新たな物性予測モデルを作るよう機械学習適用も可能。 ● High throughput計算を行い、実験できないような多数の候補に対して探索を行う 計算資源のスケールを生かせる資産をユーザー側でためていくことができる Matlantisユーザー側で蓄積していく資産

- 24. 24 Synergy

- 25. 25 ● 未だ、計算化学で現実に起こる現象を説明するには、大きな課題も多い ○ 精度の壁 ■ DFTでも、現象の再現には精度が足りない場合も ○ 空間スケール・時間スケールの壁 ■ 原子シミュレーションで扱えるスケールは現実スケールとは程遠い Matlantisの課題

- 27. 27 ● Matlantisでは直接計算できない物性値も多数存在 ○ 原子スケールよりマクロな現象(原子数の壁) ○ ps スケールより長い時間かかるような現象 (時間スケールの壁) ● Matlantisを利用して、MI用の “よい特徴量” を計算する。 ○ 最終計算したい物性値と“相関のある” 物性値をMatlantisで計算し、 実験データベースと組み合わせて、予測モデルを作成 Materials Informaticsとのシナジー: スケールの壁

- 28. 28 Appendix

- 29. 29 ● PaLMのPromptの例 ● Example input/output を工夫して与えることで 問題の解答だけでなく、 その思考過程も記述する 事が可能。 Foundation Model (基盤モデル)

- 30. Making the real world computable

![7

● PFNは将来の計算力向上を見据えた研究開発のため、自社で計算資源を保有

○ https://www.preferred.jp/ja/news/tag/cluster/

PFNで保有する自社クラスター

クラスター 主な計算資源

MN-1 (運用終了) [GPU] P100 x 8: 128台

MN-1b (運用終了) [GPU] V100 x 8: 64台

MN-2a

[GPU] V100 x 8: 128台

[CPU] Xeon 36 core: 32台

MN-2b

[GPU] A100 x 6: 42台

[GPU] A30 x 6: 42台

MN-3a [MN-core] MN-core x 4: 48台](https://image.slidesharecdn.com/20221111qparcpfnnakago-221117091052-265b770a/85/2030-2022-11-11-QPARC-7-320.jpg)