Memoria

- 1. Coordinación y control de robots móviles basado en agentes. PROYECTO FINAL DE CARRERA AUTOR: ADRIÁN CERVERA ANDÉS DIRECTORES: DR. ÁNGEL VALERA FERNÁNDEZ DRA. MARINA VALLÉS MIQUEL Valencia, julio de 2011

- 2. 2

- 3. 3 A los que quiero: a mi familia y amigos. A mis padres y hermana, por su constante apoyo. A mis abuelos, especialmente a mi abuelo Toni, por enseñarme tanto. A mis directores, por su ayuda y colaboración. “Hay una fuerza motriz más poderosa que el vapor, la electricidad y la energía atómica: la voluntad” Albert Einstein

- 4. 4 Índice: 1.- INTRODUCCIÓN_____________________________________________________9 1.1. Introducción………………………………………………………………………..…………….……………9 1.2. Objetivos…………………………………………………………………………….…………………………10 2.- DESARROLLO TEÓRICO I: ROBÓTICA____________________________________12 2.1. Introducción a la robótica……………………………………………………………………………. 12 2.2. Historia de la robótica antigua……………………………………………………………………… 12 2.3. Tipos de robots………………………………………………………………….………………………… 19 2.3.1. Robots Industriales………………………………………………….………………………….19 2.3.1.1. Robots industriales de primera generación……………………………..19 2.3.1.2. Robots industriales de segunda generación.…………………………...20 2.3.1.3. Robots industriales de tercera generación…….…………………………21 2.3.1.4. Robots industriales de cuarta generación……..…………………………21 2.3.1.5. Robots industriales de quinta generación……..…………………………22 2.3.2. Robots móviles……………………………………………………………………………………23 2.3.2.1. Robots rodantes………………………………………………………………………23 2.3.2.2. Robots andantes………………………………………………………………………25 2.3.2.3. Robots reptadores……………………………………………………………………26 2.3.2.4. Robots nadadores……………………………………………………………………27 2.3.2.5. Robots voladores…………..…………………………………………………………27 2.4. Sistemas de control…………………………….…………………………………………………………28 2.4.1. Sistemas en bucle abierto……………………………………………………………………28 2.4.2. Sistemas en bucle cerrado…………………………………………………………………..29 2.5. Comunicaciones inalámbricas…………….…………………………………………………………29 2.5.1. Wi-Fi……………………………………………………………………………………………………30 2.5.2. Bluetooth………………………………….…………………………………………………………31

- 5. 5 2.5.2.1. Wibree…………………………………………………………………………………….32 2.5.3. Zigbee………………………………………………………………………………………………….32 2.6. LEGO NXT………………………………………………………………………………………………………35 2.6.1. Introducción………………………………………………………………………………………..35 2.6.2. Ladrillo NXT…………………………………………………………………………………………35 2.6.2.1. Microcontrolador…………………………………………………………………….36 2.6.2.2. Entradas y salidas…………….………………………………………………………36 2.6.2.3. Comunicaciones……………….………………………………………………………37 2.6.3. Motores………………………………………………………………………………………………37 2.6.4. Sensores………………………………………………………………………………………………38 2.6.4.1. Sensores originales de LEGO……………………………….……………………38 2.6.4.2. Sensores de terceros…………………………………………………………..……40 2.6.5. Programación………………………………………………………………………………………41 3.- DESARROLLO TEÓRICO II: TECNOLOGÍA AGENTE__________________________44 3.1. Historia………………………………………………….………………………………………………………44 3.2. ¿Qué es una agente software? ……………….…………………………………………………….44 3.3. Tipos de agentes………………………………….………………………………………………………..47 3.4. ¿Por qué agentes? ……………………………….……………………………………………………....49 3.5. Comunicación entre agentes…………………………………………………………………………50 3.5.1. Introducción…………………………………………………………………………………..……50 3.5.2. Organizaciones de estandarización.………………………………………………….…51 3.5.2.1. OMG……………………………………………………………………………………..…51 3.5.2.2. KSE……………………………………………………………………………………..……52 3.5.2.3. FIPA………………………………………………………………………………….………52 3.6. FIPA (Foundation for Intelligent Physical Agents) …………………………………….……53 3.6.1. Modelo de referencia de FIPA………………………………………………………..……53

- 6. 6 3.6.2. Comunicación FIPA – FIPA ACL………………………………………………………….…55 3.7. JADE (Java Agent DEvelopment Framework) ………………………………………………..57 3.7.1. La plataforma de agentes JADE………………….……………………………………..…57 3.7.2. Comportamientos…………………………………….…………………………………………58 3.7.2.1. Planificación y ejecución de comportamientos…………………………58 3.7.2.2. Tipos de comportamientos………………………………………………………60 3.7.3. Directorio y servicios……………………………………………………………………………61 3.7.3.1. Publicación de servicios……………………………………………………………62 3.7.3.2. Busqueda de servicios………………………………………………………..……63 3.7.4. Comunicacion entre agentes…………………………………….…………………………64 3.7.4.1. Envio de mensajes……………………………………………………………………64 3.7.4.2. Recepción de mensajes……………………………………………………………65 4.- DESARROLLO PRÁCTICO______________________________________________66 4.1. Configuración inicial………………………………………………………………………………………66 4.1.1. Instalación del JAVA JDK………………………………………………………………………66 4.1.2. Instalación del driver USB de Lego………………………………………………….……66 4.1.3. Instalación de Lego NXJ………………………………………………………………….……66 4.1.4. Instalación y configuración de la plataforma JADE….………………………..…67 4.1.5. Configuración del entorno de desarrollo (ECLIPSE) ………………………….…69 4.1.5.1. Compilación y ejecución para NXJ……………………………………………69 4.1.5.2. Compilación y ejecución de agentes JADE…….……………………….…72 4.2. Herramientas de administración y depuración………………………………………………75 4.2.1. Lanzamiento de agentes usando la interfaz……………..…………………….……75 4.2.2. Envío de mensajes ACL…………………………………………….…………………….……76 4.2.3. Dummy Agent………………………………………………………….…………………….……78 4.2.4. DF (Directory Facilator) GUI……………………………………….………………..………79

- 7. 7 4.2.5. Sniffer Agent…………………………………………………………………………………….…81 4.2.6. Instrospector Agent…………………………………………………….………………………82 4.3. Distribución de la aplicación en varios PCs……………………………..…………….…….…83 4.4. Java Threads: Concurrencia en JAVA…………………………………………………….…….…85 4.5. Aplicación I: Robots limpiadores…………………………………………….…………….…….…86 4.5.1. Introducción……………………………………………………………………………….….……86 4.5.2. Descripción del escenario……………………………………………………………………86 4.5.3. Captura y procesamiento de imágenes……………………….………………………87 4.5.4. Programación de los algoritmos………………………………….………………………90 4.5.4.1. AgenteCámara…….……………………..……………………………………………90 4.5.4.2. AgenteLimpiador………………………..……………………………………………92 4.5.4.3. Código robots………………………………………………….…………….…………93 4.6. Aplicación II: Generación de convoyes………………………………….…………………….…93 4.6.1. Introducción……………………………………………………………….…………………….…93 4.6.2. Descripción del escenario……………………………………………………………………93 4.6.2.1. Configuración del robot líder del convoy……………….…………………94 4.6.2.2. Configuración del robot seguidor………….…………………………………95 4.6.3. Programación del algoritmo……………………………………………..…………………96 4.6.3.1. AgenteLider………………………………………………………………..……………96 4.6.3.2. AgenteSeguidor………………………………………………………….……………97 4.6.3.3. AgenteSolicitador……………………………………………….……………………97 4.6.3.4. Programación de los robots………………………………….……….…………98 4.6.3.5. Programación de la cámara NXTCam……………………………….………99 4.6.3.6. Algoritmos de evasión de obstáculos…………………….…………….…101 4.6.3.7. División de convoyes………………………………………………………..……103 4.6.3.8. Abandono del convoy por batería agotada……………..……..………105

- 8. 8 4.7. Problemas encontrados y soluciones……………………………………….…………….……106 4.7.1. Problemas por luz ambiental………………………………………….…………………106 4.7.2. Conexión Bluetooth y Threads………………………………………..…………………107 5.- CONCLUSIONES____________________________________________________109 6.- BIBLIOGRAFÍA_____________________________________________________110 Anexo A. Programación de agentes con comportamientos……………………………………111 Anexo B. Programación y utilización del sensor NXTCam………………………………………116

- 9. 9 1.- INTRODUCCIÓN 1.1. Introducción y justificación Vivimos en una sociedad en la que las necesidades de comunicación se han incrementado de forma exponencial, hasta el extremo que necesitamos estar constantemente conectados entre nosotros. La utilización y proliferación de internet ha sido, sin duda, una de las causantes de este fenómeno. En concreto, en Europa, más del 50% de las personas disponen de una conexión con la que acceder a los contenidos de la red de redes. Esto, junto con la aparición de dispositivos que utilizan métodos de acceso inalámbrico (como portátiles, móviles, PDAs, tabletas y netbooks) hacen que cada día sean más las personas que deciden utilizar estas tecnologías. Este crecimiento en su utilización ha dado lugar a un incesante trabajo por encontrar tecnologías de información cada vez más potentes y con mayores prestaciones, desarrollando protocolos de comunicaciones inalámbricas como Wi-Fi, Bluetooth y WiMax. Al mismo tiempo, las tecnologías electrónicas y mecánicas también han evolucionado, incrementando la capacidad de cómputo a precios muy asequibles. La unión de estas ciencias ha dado lugar a disciplinas como la mecatrónica, sinergia que une la ingeniería mecánica, la ingeniería electrónica y la ingeniería informática, y que tiene como objetivo utilizar un computador en la automatización y control de dispositivos mecánicos y electrónicos. La mecatrónica nos rodea en nuestro día a día, en casa (lavadora, televisión, microondas), en el trabajo (aire acondicionado, calefacción, fotocopiadora), mientras conducimos, etc. Nos permite incluso controlar nuestra casa de forma automática y remota (domótica) o solucionar problemas físicos en los seres humanos (biónica). El uso masivo de Internet ha propiciado también la aparición de aplicaciones basadas en agentes, desarrolladas sobre distintas plataformas. La interoperabilidad entre distintas plataformas de agentes es una característica crítica para el desarrollo de aplicaciones heterogéneas. Para conseguir esta interoperabilidad es muy importante el uso de las especificaciones propuestas por FIPA, organización encargada de la producción de estándares en el área de los agentes. Actualmente, el concepto de robótica ha evolucionado hacia los sistemas móviles autónomos, que son aquellos que son capaces de desenvolverse por sí mismos en entornos desconocidos y parcialmente cambiantes sin necesidad de supervisión. Uno de los grandes retos de la robótica se basa en la colaboración y autodeterminación de sus movimientos, buscando que los robots puedan trabajar de una forma lo más autónoma e independiente del ser humano posible. Para ello, deberán hacer uso de

- 10. 10 todas sus posibilidades, siendo las más importantes la sensorización, el control y la comunicación. Este proyecto engloba el uso de las nuevas tecnologías mecánicas y electrónicas, como los robots de Lego Mindstorms NXT, con el uso de últimas tecnologías en comunicación, como el Bluetooth, y con el estudio y utilización de las nuevas tecnología agente, a través de la cual podemos obtener soluciones para la colaboración y la coordinación de robots móviles, además de ayudar a la integración de distintos robots para la consecución de nuestros objetivos. 1.2. Objetivos Este proyecto pretende dotar de capacidades de autonomía y cooperación a una holarquía de robots móviles, que permitan una respuesta dinámica y cooperativa frente a posibles situaciones cambiantes (en su entorno) por medio de la adaptación y/o evolución de la propia estructura organizativa, de tal manera que ésta sea capaz de detectar situaciones de interés (por ejemplo, necesidad de adaptación para maximizar el desempeño del sistema o para mejorar la solución), y que pueda manejarlo maximizando la flexibilidad y la capacidad de respuesta ante el cambio. En este proyecto se trabajará en modelos basados en agentes para lograr la implementación de un modelo de cooperación o comunicación entre los distintos nodos de control locales, con el fin de lograr un objetivo común. Los agentes de control, diseñados específicamente para cumplir las restricciones de estabilidad, robustez y tiempo real en entornos de control distribuido, deben poder ser capaces de comunicarse de forma segura y tomar decisiones de forma conjunta para lograr objetivos comunes, no sólo entre nodos locales y un agente global supervisor, sino en un nivel horizontal, con canales de comunicación entre los propios agentes o nodos locales. Además, se buscan métodos para poder integrar distintas plataformas, con distinto hardware, para la consecución de un objetivo común. En concreto, en el proyecto se han resuelto las siguientes actividades: Se ha diseñado un modelo holónico adaptativo basado en agentes para entornos dinámicos cooperativos. Se han implementado varias soluciones en las cuales se establece la comunicación y la coordinación entre distintos agentes.

- 11. 11 Se han creado agentes que se encargan del control de los distintos robots móviles, los cuales permiten que éstos trabajen de forma coordinada y colaborativa. Se ha desarrollado el sistema de comunicaciones necesario para poder intercambiar información entre más de un robot simultáneamente sin colisiones, mediante la utilización de un único dispositivo Bluetooth. Se ha conseguido distribuir la aplicación en más de un computador, siendo capaces los agentes de intercambiar información a través de la red, facilitando la incorporación de robots y la escalabilidad de la solución.

- 12. 12 2.- DESARROLLO TEÓRICO I: ROBÓTICA 2.1. Introducción a la robótica. La imagen del robot como máquina a semejanza con el ser humano ha prevalecido en las culturas desde hace muchos siglos. El afán por fabricar máquinas capaces de realizar tareas independientes ha sido una constante en la historia, a través de la que se han descrito infinidad de ingenios, antecesores directos de los actuales robots. El término “robot” fue utilizado por primera vez por Karel Capek en su obra de teatro “R.U.R.” (Rossum’s Universal Robots) la cual fue escrita en colaboración con su hermano Josef y publicada en 1920. La palabra “robot” viene del vocablo checo “robota” que significa “trabajo”, en el sentido de la obligatoriedad, entendido como servidumbre, trabajo forzado o esclavitud, en referencia sobre todo a los llamados “trabajadores alquilados” que vivieron en el Imperio Austrohúngaro hasta 1848. Este concepto entronca con la terminología “amo-esclavo” de los robots actuales, cuando las unidades basan cada movimiento en una orden humana. En “R.U.R.” se desarrolla el concepto de la fabricación en línea ejecutada por robots humanoides, tanto desde el punto de vista narrativo como filosófico. Años más tarde la novela fue adaptada al cine en la película “Metrópolis” y el término robot quedó fijado para ese significado. 2.2. Historia de la robótica antigua Se tiene constancia que ya, en el año 1300 a.C., Amenhotep, hijo de Hapu, hace construir una estatua de Memón, rey de Etiopía, que emite sonidos cuando la iluminan los rayos de sol al amanecer. Los egipcios fueron los primeros en desarrollar modelos matemáticos muy avanzados y en construir automatismos sofisticados, como el reloj de agua. Se tiene constancia de la existencia del ábaco ya entre el año 1000 y 500 a.C., aunque existen dudas de si fue en Babilonia o en China donde fue inventado. Este ingenio matemático permitió el desarrollo de la computación y la inteligencia artificial que fueron desarrollándose paralelamente al interés por los automatismos y el diseño de máquinas imitadoras del ser humano. Todavía en el 500 a.C., King-su Tse inventa en China una urraca voladora de madera y bambú, y un caballo de madera capaz de dar saltos. Hacia el 200 a.C., Filón de Bizancio, inventor de la catapulta repetitiva, construye un autómata acuático. Años más tarde, en el año 206 a.C., durante el reinado del primer emperador Han, fue encontrado el tesoro de Chin Shih Huang Ti, consistente en una orquesta mecánica de muñecos que se movían de una forma independiente. En la antigua Grecia, Arquitas de Tarento, filósofo, matemático y político coetáneo de Platón, considerado el padre de la ingeniería mecánica y precursor occidental de la

- 13. 13 robótica, inventó el tornillo y la polea, entre otros muchos dispositivos. Fabricó el primer cohete autopropulsado de la historia, que usó con fines militares. Hacia el año 400 a. C. construyó un autómata consistente en una paloma de madera que rotaba por si sola gracias a un surtidor de agua o vapor y simulaba el vuelo. Hacia el 300 a. C., Ctesibio inventa un reloj de agua (o clepsidra) y un órgano que emite los sonidos por impulsos de agua. En el año 62 de nuestra era Heron de Alejandría muestra, en su libro “Autómata”, los diseños de juguetes capaces de moverse por si solos de forma repetida, como aves que vuelan, gorjean y beben; o ingenios que funcionaban a partir de la fuerza generada por aspas de molino o circuitos de agua en ebullición, precursores rudimentarios de la turbina de vapor. Figura 1: Herón de Alejandría junto a uno de sus inventos Los relojes pueden considerarse como las máquinas antiguas más perfectas, muy cercanas al concepto de automatismo y, consecutivamente, a la de robótica. Es frecuente hallar relojes que incluyen figuras humanas móviles que se mueven con el orden de las horas. El reloj de la catedral de Múnich y el reloj del Ánker de Viena son buenos ejemplos. El Gallo de Estrasburgo, el robot más antiguo que se conserva en la actualidad, funcionó desde 1352 hasta 1789. Formaba parte del reloj de la catedral y, al dar las horas, movía el pico y las alas20. En España, el Papamoscas de la catedral de Burgos, construido en el siglo XVI, consiste en un hombre mecánico que se mueve con los cambios horarios y funciona aún hoy día.

- 14. 14 Figura 2: Papamoscas de la catedral de Burgos Los autómatas más famosos del Medievo son el hombre de hierro de Alberto Magno (1204-1282) o la cabeza parlante de Roger Bacon (1214-1294). Leonardo da Vinci (1452-1519) construyó para el rey Luis XII de Francia un León Mecánico, que se abría el pecho con la garra y mostraba el escudo de armas real. Figura 3: León mecánico de Leonardo Da Vinci En la España del siglo XVI Juanelo Turriano (1500?-1585), relojero del emperador Carlos V, construye el “Hombre de Palo”, un monje autómata capaz de andar y mover la cabeza. En el siglo XVII G. W. von Leibniz (1646-1716) abogó por el empleo del sistema binario como base para el cálculo automático, sentando definitivamente las bases de la computación actual. Los materiales empleados para la construcción de autómatas eran la madera (partes formes), el hierro (estructura fija, soportes, goznes), el cobre

- 15. 15 (que es moldeable y permite construir partes más finas), el cuero (cables, calzado) y los tejidos. Los primeros modelos utilizaban la aplicación de fuerza directa para realizar los movimientos, facilitados con juegos de poleas, engranajes y palancas. Figura 4: Step Reckoner de G.W. Leibniz El desarrollo de modelos matemáticos con operativa mecánica, como el de George Boole (1815-1864), permitió pasar de la robótica clásica a la moderna tomando la computación como base. Jacques Vaucanson (1709-1782) es uno de los más famosos y completos constructores de androides automatizados de la historia. Persona de gran ingenio recorrió toda Europa presentando sus artefactos en las cortes de época. En 1738 montó un autómata flautista capaz de ejecutar melodías barrocas. El muñeco realizaba la digitación sobre el instrumento y seguía con los ojos la partitura. Además consiguió uno de los hitos más sonados de la historia de la robótica al construir un pato mecánico de más de 400 piezas móviles, capaz de graznar y comer de la mano del público, completando de forma total la digestión. En el museo de autómatas de Grenoble existe una copia del pato de Vaucanson.

- 16. 16 Figura 5: Pato de Vaucanson La construcción de miembros artificiales se remonta a Ambroise Paré (1510-1590) que desarrolló modelos de sorprendente complejidad. En 1769, el ingeniero húngaro Johann Wolfgang Ritter von Kempelen (1734-1804), construye uno de los autómatas más famosos de la historia: una máquina para jugar al ajedrez. Se trataba de un dispositivo puramente mecánico. Por su aspecto la máquina era conocida como “el turco”. Sobre la mesa había un tablero de ajedrez, y en el interior unos finos engranajes y resortes que imprimían movimiento a sus manos, que iban cambiando las fichas de posición a medida que transcurría la partida. El maniquí ganaba las partidas más complicadas y se hizo famoso en toda Europacuando derrotó por tres veces a Napoleón Bonaparte. Nadie consiguió descubrir el secreto de esta máquina y, por supuesto, todos ignoraron que se habían enfrentado en realidad al campeón de ajedrez Johann Allgaier, oculto dentro del cajón.

- 17. 17 Figura 6: Máquina para jugar al ajedrez conocida como “El Turco” En esta época los autómatas tenían sobre todo una intención lúdica y eran exhibidos en ferias y circos. Sólo después de unos años, a partir de la revolución industrial, empezaron a ser usados para funciones productivas. En 1898 Nicola Tesla (1856-1943), inventor del motor eléctrico de corriente alterna, presenta el que algunos consideran el primer robot de la historia moderna, un barco teledirigido, a partir del que patentó el Teleautomation, un torpedo teledirigido para uso militar. Figura 7: Barco teledirigido de Nicola Tesla

- 18. 18 Sin embargo, no fue hasta 1921 cuando se escuchó por primera vez la palabra robot, utilizada por el escritor checo Karel Capek en su obra de teatro R.U.R (Rossum´s Universal Robots). La palabra robot viene del vocablo checo ‘Robota’ que significa “trabajo”, entendido como servidumbre, trabajo forzado o esclavitud. Más tarde, Isaac Asimov (1920-1992) postuló las tres leyes de la robótica en su libro I Robot (Yo robot) publicado en 1950, coincidiendo con el apogeo de la robótica moderna. Los primeros robots industriales empezaron a producirse a principios de los años 60 y estaban diseñados principalmente para realizar trabajos mecánicos difíciles y peligrosos. Las áreas donde estos robots tuvieron su aplicación fueron trabajos laboriosos y repetitivos, como la carga y descarga de hornos de fundición. En 1961 el inventor norteamericano George Devol patentaba el primer robot programable de la historia, conocido como Unimate, estableciendo las bases de la robótica industrial moderna. Figura 8: Unimate Este robot industrial era un manipulador que formaba parte de una célula de trabajo en la empresa de automóviles Ford Motors Company, diseñado para levantar y apilar grandes piezas de metal caliente, de hasta 225 kg, de una troqueladora de fundición por inyección. Debido a los continuos avances en la informática y la electrónica, a partir de 1970 fueron desarrollados diversos robots programables, siendo de gran importancia en la industria mecánica, tanto en las líneas de ensamblaje como en aplicaciones como la soldadura o pintura. En los últimos años, los robots han tomado posición en todas las áreas productivas industriales. La incorporación del robot al proceso productivo ha representado uno de

- 19. 19 los avances más espectaculares de la edad moderna. En poco más de cuarenta años, se ha pasado de aquellos primeros modelos, rudos y limitados, a sofisticadas máquinas capaces de sustituir al hombre en todo tipo de tareas repetitivas o peligrosas, y además, hacerlo de forma más rápida, precisa y económica que el ser humano. Hoy en día, se calcula que el número de robots industriales instalados en el mundo es de un millón de unidades, unos 20.000 en España, siendo Japón el país más tecnológicamente avanzado, con una media de 322 robots por cada 10.000 trabajadores. 2.3. Tipos de robots Aquí lo que se pretende es describir las posibles categorías en las que se pueden clasificar los robots actuales. Aunque se pueden realizar distintas clasificaciones (por grado de autonomía, por tipo de propósito, por función, por medio, por tamaño y peso, anatomía e inteligencia), aquí vamos a describir los principales tipos de robots que se utilizan en la actualidad. 2.3.1.Robots Industriales Se entiende por Robot Industrial a un dispositivo de maniobra destinado a ser utilizado en la industria y dotado de uno o varios brazos, fácilmente programable para cumplir operaciones diversas con varios grados de libertad y destinado a sustituir la actividad física del hombre en las tareas repetitivas, monótonas, desagradables o peligrosas. Por su parte, la Organización Internacional de Estándares (ISO) que define al robot industrial como un manipulador multifuncional reprogramable con varios grados de libertad, capaz de manipular materias, piezas, herramientas o dispositivos especiales según trayectorias variables programadas para realizar tareas diversas. Una clasificación del grado de complejidad del Robot puede establecerse de la siguiente forma: 2.3.1.1. Robots de primera generación Dispositivos que actúan como "esclavo" mecánico de un hombre, quien provee mediante su intervención directa el control de los órganos de movimiento. Esta transmisión tiene lugar mediante servomecanismos actuados por las extremidades superiores del hombre, caso típico manipulación de materiales radiactivos, obtención de muestras submarinas, etc.

- 20. 20 El sistema de control usado en la primera generación de robots esta basado en la “paradas fijas” mecánicamente. Esta estrategia es conocida como control de lazo abierto o control “bang bang”. Figura 9: Robot de primera generación 2.3.1.2. Robots de segunda generación El dispositivo actúa automáticamente sin intervención humana frente a posiciones fijas en las que el trabajo ha sido preparado y ubicado de modo adecuado ejecutando movimientos repetitivos en el tiempo, que obedecen a lógicas combinatorias, secuenciales, programadores paso a paso, neumáticos o Controladores Lógicos Programables. Utiliza una estructura de control de ciclo abierto, pero en lugar de utilizar interruptores y botones mecánicos utiliza una secuencia numérica de control de movimientos almacenados en un disco o cinta magnética. El mayor número de aplicaciones en los que se utilizan los robots de esta generación son de la industria automotriz, en soldadura, pintado, etc.

- 21. 21 Figura 10: Robot de segunda generación de ABB 2.3.1.3. Robots de tercera generación La tercera generación de robots utiliza las computadoras para su estrategia de control y tiene algún conocimiento del ambiente local a través del uso de sensores, los cuales miden el ambiente y modifican su estrategia de control, con esta generación se inicia la era de los robots inteligentes y aparecen los lenguajes de programación para escribir los programas de control. La estrategia de control utilizada se denomina de “ciclo cerrado”. Figura 11: Robot de tercera generación 2.3.1.4. Robots de cuarta generación La cuarta generación de robots, ya los califica de inteligentes con más y mejores extensiones sensoriales, para comprender sus acciones y el mundo que los rodea.

- 22. 22 Incorpora un concepto de “modelo del mundo” de su propia conducta y del ambiente en el que operan. Utilizan conocimiento difuso y procesamiento dirigido por expectativas que mejoran el desempeño del sistema de manera que la tarea de los sensores se extiende a la supervisión del ambiente global, registrando los efectos de sus acciones en un modelo del mundo y auxiliar en la determinación de tareas y metas. Figura 12: Robot de cuarta generación de ABB 2.3.1.5. Robots de quinta generación La quinta generación, actualmente está en desarrollo esta nueva generación de robots, que pretende que el control emerja de la adecuada organización y distribución de módulos conductuales, esta nueva arquitectura es denominada arquitectura de subsunción, cuyo promotor es Rodney Brooks, donde la toma de decisiones del agente (función acción) se realiza mediante un conjunto de módulos de comportamiento que realizan tareas. Un modulo de comportamiento suele implementarse como un autómata finito sin ningún tipo de representación o razonamiento simbólico. Casi siempre el comportamiento se implementa como reglas del tipo: Si (situación) entonces (acción), donde situación se toma directamente de la percepción, sin ningún tipo de transformación a representación simbólica. La selección del comportamiento se basa en la jerarquía de subsunción. Los comportamientos están ordenados por capas y los de las capas mas bajas (máxima prioridad) inhiben a los de las capas superiores (comportamiento más abstracto). Este proyecto final de carrera estaría clasificado en esta generación de robots, ya que sigue

- 23. 23 la investigación de la toma de decisiones por parte de uno o varios agentes, el cual se encarga de la activación de los comportamientos necesarios. Figura 13: Esquema de funcionamiento de robot de quinta generación 2.3.2. Robótica Móvil En el apartado anterior se ha realizado un desglose de los diferentes tipos de robots existentes atendiendo a su aplicación, pero más allá de este aspecto práctico hay otro hecho característico de los robots modernos que les confiere un mayor grado de libertad y utilidad. Esta característica es el movimiento en el espacio físico, es decir, la posibilidad de desplazarse por el entorno para observarlo e interactuar con él, y de esta forma emular con mayor fidelidad las funciones y capacidades de los seres vivos. 2.3.2.1. Robots rodantes Son aquellos que, como su nombre indica, se desplazan haciendo uso de ruedas. Podemos encontrar varias configuraciones para la posición y el número de ruedas. La primera de ellas sería la configuración de Ackerman, la cual se usa casi exclusivamente en la industria del automóvil. Es la configuración que llevan los coches: dos ruedas con tracción traseras, y dos ruedas de dirección delanteras. Esta configuración está diseñada para que la rueda delantera interior en un giro tenga un ángulo ligeramente más agudo que la exterior, y evitar así el derrape de las ruedas.

- 24. 24 Figura 14: Robot con configuración de Ackerman También es frecuente encontrar distribuciones de ruedas montadas en configuración diferencial (triciclo) se presenta como la más sencilla de todas. Consta de dos ruedas situadas diametralmente opuestas en un eje perpendicular a la dirección del robot más una rueda loca. Estas ruedas no llevan asociadas ningún motor, giran libremente según la velocidad del robot. Además, pueden orientarse según la dirección del movimiento, de forma análoga a como lo hacen las ruedas traseras de los carritos del supermercado Figura 15: Robot en configuración triciclo Existen algunos casos especiales en los que se usan otras configuraciones que dotan al robot de mejor adaptación a terrenos difíciles. En estos casos los algoritmos de control de movimiento adquieren una mayor complejidad, proporcional al número de elementos direccionales de forma independiente.

- 25. 25 Figura 16: Robot Koala El último grupo de robots que aquí convendría nombrar es el de los robots que se desplazan mediante la utilización de cadenas. Para la realización de los giros es necesario que ambas cadenas giren en sentidos opuestos dependiendo de cual sea el sentido de giro final del robot, de modo parecido al que se utiliza en la configuración diferencial. Figura 17: Robot rodante Meccano Spykee 2.3.2.2. Robots andantes Los robots andantes son aquellos que basan su movilidad en la simulación de los movimientos realizados por los seres humanos al andar. Estos robots están provistos de dos patas con varios grados de libertad, a través de las cuales son capaces de

- 26. 26 desplazarse manteniendo el equilibrio. No obstante, este tipo de robots son los más inestables que se encuentran en la actualidad, y los esfuerzos se aúnan en intentar conseguir técnicas de estabilidad y equilibro que eviten que el robot se desestabilice y vuelque en situaciones adversas, como al correr, subir una cuesta, sortear obstáculos, etc. Sin embargo, podemos encontrar modelos avanzados de este tipo de robot que son capaces de caminar, gatear, bailar e incluso trotar a velocidades de 5 kilómetros/hora. Figura 18: Robot andante de Honda. 2.3.2.3. Robots reptadores Las características que se buscan son: flexibilidad, versatilidad y adaptabilidad. Están formados por módulos en conexión de viraje-viraje (yaw-yaw) con ruedas pasivas, logrando una propulsión similar a la de las serpientes biológicas.

- 27. 27 Figura 19: Robot reptador 2.3.2.4. Robots nadadores Estos robots son capaces de desenvolverse en el medio acuático, generalmente enfocados a tareas de exploración submarina en zonas donde no es posible llegar pos ser de difícil acceso o estar a profundidades que el cuerpo humano no tolera. Figura 20: Robot ballena 2.3.2.5. Robots voladores Este tipo de robots son capaces de desplazarse por el aire, del mismo modo que un avión o un helicóptero. Para ello, incorporan una serie de hélices que se encargan de generar la fuerza necesaria para elevar el robot y de realizar los giros pertinentes para seguir una determinada trayectoria.

- 28. 28 Figura 21: Cuadricóptero Ar Drone de Parrot 2.4. Sistemas de control La aplicación del computador en el control de procesos supone un salto tecnológico enorme que se traduce en la implantación de nuevos sistemas de control en el entorno de la Industria. Desde el punto de vista de la aplicación de las teorías de control automático el computador no esta limitado a emular el cálculo realizado en los reguladores analógicos, el computador permite la implantación de avanzados algoritmos de control mucho más complejos como pueden ser el control óptimo o el control adaptativo. El controlador se encarga de almacenar y procesar la información de los diferentes componentes del robot industrial. La definición de un sistema de control es la combinación de componentes que actúan juntos para realizar el control de un proceso. Este control se puede hacer de forma continua, es decir en todo momento o de forma discreta, es decir cada cierto tiempo. Si el sistema es continuo, el control se realiza con elementos continuos. En cambio, cuando el sistema es discreto el control se realiza con elementos digitales, como el ordenador, por lo que hay que digitalizar los valores antes de su procesamiento y volver a convertirlos tras el procesamiento. Existen dos tipos de sistemas, sistemas en lazo abierto y sistemas en lazo cerrado. 2.4.1. Sistemas en bucle abierto Estos toman la información acerca de las condiciones de operación que reciben de varios sensores y entonces usan esa información para determinar –sea por medios mecánicos o usando medios electrónicos programados- exactamente que acción debe aplicarse para alcanzar la situación deseada. La precisión en la medición depende

- 29. 29 enteramente de qué tan bien el sistema –de cualquier tipo que sea- puede predecir las necesidades del motor basado en su “conocimiento” de las condiciones de operación Figura 22: Esquema bucle abierto 2.4.2. Sistemas en bucle cerrado En un sistema de lazo cerrado ó de retroalimentación, la información acerca de cualquier cosa que esté siendo controlada es continuamente retro-alimentada al sistema como un dato de entrada. La operación de un termostato en un sistema de calefacción automático es un ejemplo de control de lazo cerrado. Figura 23: Esquema bucle cerrado Para el ejemplo del termostato, conforme baja la temperatura, el termostato siente el descenso y le indica al horno que añada calor. Tan pronto como la temperatura sube más allá de lo previsto, el termostato siente el resultado de su propia acción de control –el calor producido por el horno- y le indica a éste que corte el calor. Un sistema de lazo abierto puede, por ejemplo, sentir la baja de temperatura y simplemente encender el calor por un predeterminado lapso de tiempo; sin embargo el control de lazo cerrado es automático, la temperatura permanece relativamente constante, y el consumo de energía probablemente se reduce. De todas maneras, el resultado es un control mejor y más preciso. 2.5. Comunicaciones inalámbricas

- 30. 30 La comunicación inalámbrica o sin cables es aquella en la que extremos de la comunicación (emisor/receptor) no se encuentran unidos por un medio de propagación físico, sino que se utiliza la modulación de ondas electromagnéticas a través del espacio. En este sentido, los dispositivos físicos sólo están presentes en los emisores y receptores de la señal. A continuación se detallarán los principales protocolos de comunicación inalámbrica en el ámbito de la robótica. 2.5.1. Wi-Fi Wi-Fi es un estándar para la conexión de dispositivos electrónicos mediante tecnología inalámbrica. Hoy en día, la mayor parte de los dispositivos que utilizamos incorporan esta tecnología (teléfonos, consolas, portátiles, etc.) con la que podemos conectarnos a una red (o Internet) sin la necesidad de utilizar cables. Para la conexión tenemos dos modos de acceso posibles: (AP) Access point: Permite al resto de dispositivos conectarse a una red inalámbrica, centralizando las conexiones en un único dispositivo. Normalmente está conectado a un encaminador (router) que se encarga de conectar la red inalámbrica con Internet. Ad-hoc: Permite el intercambio de información entre varios dispositivos de forma descentralizada, sin la necesidad de utilizar una infraestructura ajena para la conexión. Wi-Fi es una marca de la Wi-Fi Alliance, la organización comercial que adopta, prueba y certifica que los equipos cumplen los estándares 802.11 relacionados a redes inalámbricas de área local. El alcance de una red Wi-Fi está alrededor de los 100 metros al aire libre, reduciéndose esta distancia con la presencia de obstáculos como paredes. Los estándares de Wi-Fi IEEE 802.11b, IEEE 802.11g e IEEE 802.11n disfrutan de una aceptación internacional debido a que la banda de 2.4 GHz está disponible casi universalmente, con una velocidad de hasta 11 Mbps , 54 Mbps y 300 Mbps, respectivamente. En cuanto a los protocolos de seguridad que utiliza existen varias alternativas para garantizar la seguridad de estas redes. Las más comunes son la utilización de protocolos de cifrado de datos para los estándares Wi-Fi como el WEP, el WPA, o el WPA2 que se encargan de codificar la información transmitida para proteger su confidencialidad, proporcionados por los propios dispositivos inalámbricos. La mayoría de las formas son las siguientes: WEP, cifra los datos en su red de forma que sólo el destinatario deseado pueda acceder a ellos. Los cifrados de 64 y 128 bits son dos niveles de seguridad WEP.

- 31. 31 WEP codifica los datos mediante una “clave” de cifrado antes de enviarlo al aire. Este tipo de cifrado no está muy recomendado, debido a las grandes vulnerabilidades que presenta, ya que cualquier cracker puede conseguir sacar la clave. WPA: presenta mejoras como generación dinámica de la clave de acceso. Las claves se insertan como de dígitos alfanuméricos, sin restricción de longitud Sin embargo, su uso esta más encaminado a la conectividad de dispositivos que buscan un largo alcance y gran ancho de banda, independientemente de otros factores tan importantes en los robots móviles como puede ser el consumo de las baterías. Figura 24: Logotipo Wi-Fi 2.5.2. Bluetooth Bluetooth es una especificación industrial para Redes Inalámbricas de Área Personal (WPANs) que posibilita la transmisión de voz y datos entre diferentes dispositivos mediante un enlace por radiofrecuencia en la banda ISM de los 2,4 GHz. Los principales objetivos que se pretenden conseguir con esta norma son: Facilitar las comunicaciones entre equipos móviles y fijos. Eliminar cables y conectores entre éstos. Ofrecer la posibilidad de crear pequeñas redes inalámbricas y facilitar la sincronización de datos entre equipos personales. Se denomina Bluetooth al protocolo de comunicaciones diseñado especialmente para dispositivos de bajo consumo, con baja cobertura y basados en transceptores de bajo coste. Gracias a este protocolo, los dispositivos que lo implementan pueden comunicarse entre ellos cuando se encuentran dentro de su alcance. Las comunicaciones se realizan

- 32. 32 por radiofrecuencia de forma inalámbrica. Estos dispositivos se clasifican como "Clase 1", "Clase 2" o "Clase 3" en referencia a su potencia de transmisión, siendo totalmente compatibles los dispositivos de una clase con los de las otras. En cuanto al ancho de banda que nos proporciona una conexión Bluetooth, la versión 1.2 de la especificación consigue transmisión de datos a 1Mbps, la versión 2.0 alcanza los 3Mbps, mientras que la última versión 3.0 ofrece hasta 24Mbps, buscando la compatibilidad con Wi-Fi. Figura 25: Logotipo Bluetooth 2.5.2.1. Wibree A partir de la especificación Bluetooth apareció el 12 de junio de 2007 la especificación Wibree. Fue anunciada como una parte de la especificación de Bluetooth encaminada a ser una versión de muy bajo consumo. Sus aplicaciones son principalmente dispositivos sensores o mandos a distancia. Puede resultar interesante para equipamiento médico. Wibree es una nueva tecnología digital de radio interoperable para pequeños dispositivos. Es la primera tecnología abierta de comunicación inalámbrica, que ofrece comunicación entre dispositivos móviles o computadores y otros dispositivos más pequeños (de pila de botón), diseñada para que funcione con poca energía. Figura 26: Logotipo WiBree 2.5.3. Zigbee

- 33. 33 ZigBee es el nombre de la especificación de un conjunto de protocolos de alto nivel de comunicación inalámbrica para su utilización con radiodifusión digital de bajo consumo, basada en el estándar IEEE 802.15.4 de redes inalámbricas de área personal (wireless personal area network, WPAN). Su objetivo son las aplicaciones que requieren comunicaciones seguras con baja tasa de envío de datos y maximización de la vida útil de sus baterías. En principio, el ámbito donde se prevé que esta tecnología cobre más fuerza es en domótica, como puede verse en los documentos de la ZigBee Alliance. La razón de ello son diversas características que lo diferencian de otras tecnologías: Su bajo consumo. Su topología de red en malla. Su fácil integración (se pueden fabricar nodos con muy poca electrónica). Uno de los objetivos de la especificación de ZigBee es ser más simple y barato que otras tecnologías encaminadas a WPANs como puede ser Bluetooth. Si principal campo de integración son aplicaciones que necesitan un reducido tráfico de datos, un bajo consumo de sus baterías y unas conexiones lo más seguras posibles. Estas características hacen que sea ampliamente utilizado en las siguientes aplicaciones: 1. Automoción 2. Aplicaciones industriales 3. Aviónica 4. Entornos inteligentes 5. Domótica y seguridad 6. Monitorización del medio ambiente 7. Identificación de productos 8. Etc. Este estándar define dos capas físicas: a 868/915 MHz DSSS PHY (espectro con propagación de secuencia directa) y otra a 2450 MHz DSSS PHY. La capa de 2450 MHz soporta un rango de datos de 250 Kb/s y la de 868/915 un rango de datos entre los 20 Kb/s y 40 Kb/s. La elección de cada una de las capas depende de las regulaciones locales y de las preferencias del usuario. Las principales diferencias respecto a Bluetooth son las siguientes:

- 34. 34 Una red ZigBee puede constar de un máximo de 65535 nodos distribuidos en subredes de 255 nodos, frente a los 8 máximos de una subred (Piconet) Bluetooth. Menor consumo eléctrico que el de Bluetooth. En términos exactos, ZigBee tiene un consumo de 30 mA transmitiendo y de 3 uA en reposo, frente a los 40 mA transmitiendo y 0,2 mA en reposo que tiene el Bluetooth. Este menor consumo se debe a que el sistema ZigBee se queda la mayor parte del tiempo dormido, mientras que en una comunicación Bluetooth esto no se puede dar, y siempre se está transmitiendo y/o recibiendo. Tiene una velocidad de hasta 250 Kbps, mientras que en Bluetooth es de hasta 3 Mbps. Debido a las velocidades de cada uno, uno es más apropiado que el otro para ciertas cosas. Por ejemplo, mientras que el Bluetooth se usa para aplicaciones como los teléfonos móviles y la informática casera, la velocidad del ZigBee se hace insuficiente para estas tareas, desviándolo a usos tales como la Domótica, los productos dependientes de la batería, los sensores médicos, y en artículos de juguetería, en los cuales la transferencia de datos es menor. Existe una versión que integra el sistema de radiofrecuencias característico de Bluetooth junto a una interfaz de transmisión de datos vía infrarrojos desarrollado por IBM mediante un protocolo ADSI y MDSI. Figura 27: Logotipo ZigBee Alliance Actualmente ya podemos encontrar un dispositivo ZigBee para la transferencia de datos entre robots Lego Mindstorms NXT. Dicho hardware se conecta al ladrillo del NXT como un sensor más y es capaz de conectar entre si una gran cantidad de robots NXT. Su alcance le permite enviar datos hasta una distancia de 1200 metros en exterior y más de 90 metros en interior.

- 35. 35 Figura 28: Dispositivo ZigBee para Lego NXT 2.6. LEGO NXT 2.6.1. Introducción Lego Mindstorms es un kit de robótica fabricado por la empresa Lego, el cual posee elementos básicos de las teorías robóticas, como la unión de piezas y la programación de acciones, en forma interactiva. Este robot fue comercializado por primera vez en septiembre de 1998. Comercialmente se publicita como «Robotic Invention System», en español Sistema de Invención Robotizado (RIS). También se vende como herramienta educacional, lo que originalmente se pensó en una sociedad entre Lego y el MIT. La versión educativa se llama «Lego Mindstorms for Schools», en español Lego Mindstorms para la escuela y viene con un software de programación basado en la GUI de Robolab. Lego Mindstorms puede ser usado para construir un modelo de sistema integrado con partes electromecánicas controladas por computador. Prácticamente todo puede ser representado con las piezas tal como en la vida real, como un elevador o robots industriales. Lego Mindstorms fue uno de los resultados de la fructífera colaboración entre Lego y el MIT. Esta asociación se emplea como ejemplo de relación entre la industria y la investigación académica que resulta muy beneficiosa para ambos socios. La línea Lego Mindstorms nació en una época difícil para Lego, a partir de un acuerdo entre Lego y el MIT. Según este trato, Lego financiaría investigaciones del grupo de epistemología y aprendizaje del MIT sobre cómo aprenden los niños y a cambio obtendría nuevas ideas para sus productos, que podría lanzar al mercado sin tener que pagar regalías al MIT. Un fruto de esta colaboración fue el desarrollo del MIT Programmable Brick (Ladrillo programable). 2.6.2. Ladrillo NXT

- 36. 36 El bloque NXT es una versión mejorada a partir de Lego Mindstorms RCX, que generalmente se considera la predecesora y precursora de los bloques programables de Lego. Debido a la comercialización de los bloques programables, Lego vendió la generación NXT en dos versiones: Retail Version y Education Base Set. Una ventaja de la versión Educacional es que se incluía las baterías recargables y el cargador, pero esta misma versión debía comprar el software según el tipo de licencia: Personal, Sala de clases, Sitio. Figura 29: Ladrillo del Lego NXT 2.6.2.1. Microcontrolador El microcontrolador que posee es un ARM7 de 32 bits, que incluye 256 Kb de memoria Flash y 64 Kb de RAM externa, la cual a diferencia del bloque RCX, posee mayores capacidades de ejecución de programas, evitando que los procesos inherentes de varios paquetes de datos colisionen y produzcan errores y un posible error en la ejecución del software. Su presentación es similar al Hitachi H8 ya que se encuentra en el circuito impreso del bloque, junto a la memoria FLASH. 2.6.2.2. Entradas y salidas En el bloque de NXT existen cuatro entradas para los sensores, pero los conectores son distintos de los del RCX, lo que impide la conexión de sus motores o sensores, sin embargo, el kit de NXT incluye el adaptador para que los sensores de RCX sean compatibles con NXT.16

- 37. 37 Las salidas de energía son tres, localizadas en la parte posterior del bloque, haciendo que la conexión para los motores y partes móviles sean de más fácil acceso. 2.6.2.3. Comunicaciones El bloque de NXT puede comunicarse con el computador mediante la interfaz de USB que posee, la cual ya viene en la versión 2.0. Además, para comunicarse con otros robots en las cercanías posee una interfaz Bluetooth. Esta conectividad con Bluetooth no tan sólo permite conectarse con otros bloques, sino también con computadores, teléfonos móviles, y otros aparatos con esta interfaz de comunicación. Dentro de las posibilidades de conexión se encuentran: Conectar hasta tres dispositivos distintos Buscar y conectarse a otros dispositivos que posean Bluetooth Recordar dispositivos con los cuales se ha conectado anteriormente para conectarse más rápidamente Establecer el bloque NXT como visible o invisible para el resto de los dispositivos. 2.6.3. Motores Los motores integrados al bloque son menos versátiles, pero no dependen de conexiones externas, lo cual visualmente ayuda al robot en su presentación. El modelo NXT usa servo motores, los cuales permiten la detección de giros de la rueda, indicando los giros completos o medios giros, que es controlado por el software. El encoder o tacómetro, por su parte, permite conocer el número de vueltas que ha dado el eje del motor con una precisión de 1 grado. Es decir, si el motor realiza un giro completo el encoder verá incrementada su cuenta en 360 unidades. Esto es cierto sea cual sea el sentido de movimiento del motor, incrementándose en un sentido y decrementándose al girar en sentido contrario. Además, el control de la velocidad de los motores se realiza con una señal PWM (Pulse Width Modulation o modulación por ancho de pulso) en la que, dependiendo del ciclo de trabajo de la señal de entrada, podemos incrementar o decrementar la velocidad de los motores.

- 38. 38 Figura 30: Motor del Lego NXT 2.6.4. Sensores El robot Lego puede utilizar dos tipos distintos de sensores, tanto los originales de Lego como los que han sido construidos por terceros. 2.6.4.1. Sensores originales Lego Algunos de los sensores originales de Lego que podemos encontrar son los siguientes: Sensor de luz: El sensor de luz permite tomar una muestra de luz mediante un bloque modificado que un extremo trae un conductor eléctrico y por el otro una cámara oscura que capta las luces. Esta cámara es capaz de captar luces entre los rangos de 0,6 a 760 lux. Este valor lo considera como un porcentaje, el cual es procesado por el bloque lógico, obteniendo un porcentaje aproximado de luminosidad. La principal utilización de este sensor es la detección de líneas, en aplicaciones como el seguidor de línea, lucha de sumos, robots limpiadores, etc. Figura 31: Sensor de luz del Lego NXT Sensor de temperatura: El sensor de temperatura permite leer el valor aproximado de la temperatura, mediante la interacción de un termistor en uno de los extremos, generando un campo magnético que permite la detección aproximada de la temperatura del bloque que lo contiene. El bloque original de

- 39. 39 Lego posee un termistor de 12.2 Kohms a 25 °C con un coeficiente de corrección aproximado de un -3,7%/°C. Figura 32: Sensor de temperatura del Lego NXT Sensor de contacto: El sensor de contacto permite detectar si el bloque que lo posee ha colisionado o no con algún objeto que se encuentre en su trayectoria inmediata. Al tocar una superficie, una pequeña cabeza externa se contrae, permitiendo que una pieza dentro del bloque cierre un circuito eléctrico comience a circular energía, provocando una variación de energía de 0 a 5 V. Figura 33: Sensor de contacto del Lego NXT Sensor de giro: El sensor de giro permite conocer la posición del robot en cualquier instante.

- 40. 40 Figura 34: Sensor de giro del Lego NXT Sensor ultrasónico: su principal función detectar las distancias y el movimiento de un objeto que se interponga en el camino del robot, mediante el principio de la detección ultrasónica. Este sensor es capaz de detectar objetos que se encuentren desde 0 a 255 cm, con una precisión relativa de +/- 3 cm. Mediante el principio del eco, el sensor es capaz de recibir la información de los distintos objetos que se encuentren en el campo de detección. Figura 35: Sensor de ultrasonidos del Lego NXT 2.6.4.2. Sensores de terceros A parte de los sensores creados por Lego, podemos encontrar varios sensores creados por fabricantes externos a lego y que permiten ampliar la funcionalidad y sensorización de nuestro robot en una gran medida. Algunos de estos sensores se pueden conseguir en: HiTechnic (www.HiTechnic.com) MindSensors (www.MindSensors.com)

- 41. 41 Los sensores más importantes que podemos destacar en este apartado son los siguientes: Sensor de brújula: permite conocer cual es la orientación del robot respecto al norte magnético. Sensor de aceleración: Es capaz de medir las aceleraciones en los ejes de coordenadas. Sensor cámara: Este es uno de los más importantes y que se han utilizado a lo largo del proyecto. Este sensor es capaz de obtener imágenes del medio en el que opera y obtener su información. Su funcionamiento se detallará en secciones posteriores. Figura 36: Sensor cámara NXTCam V2 2.6.5. Programación Para la programación del robot existen varias alternativas a la programación por diagramas de cajas o arbol de decisiones que se proporciona con el robot, el cual tiene una funcionalidad bastante limitada. Para una programación utilizando lenguajes de programación de alto nivel se utilizan principalmente los siguientes lenguajes: RobotC: Entorno de desarrollo integrado que tiene como objetivo la programación del NXT o RCX bajo el lenguaje de programación C. Una de sus ventajas es que no necesita sustituir el firmware original del robot, funcionando bajo el original. Entre sus principales características tenemos una interfaz parecida a la de VisualBasic, herramientas para realizar la depuración de nuestras aplicaciones, tutoriales para aprender la sintáxis del lenguaje y permite la ejecución de distintas tareas de forma concurrente.

- 42. 42 LejOS: para la programación en este lenguaje es necesario sustituir el firmware original del brick por éste. Actualmente se puede instalar tanto en el brick RCX como en el NXT. Incluye una máquina virtual de JAVA, la cual permite al Lego Mindstorms ejecutar aplicaciones que se han implementado bajo este lenguaje. Incluye funciones para el control de prácticamente todos los sensores y actuadores, incluso de aquellos que han sido desarrollados por terceros como la brújula, el acelerómetro y la cámara. Este es el firmware que se ha utilizado para el desarrollo de nuestro proyecto. BricxCC: Bricx Command Center es un conocido IDE que soporta programación del RCX con NQC, C, C++, Pascal, Forth, y Java utilizando brickOS, pbForth y LeJOS. Con BricxCC se pueden desarrollar programas en NBC y NXC. Tanto NBC como NXC utilizan el firmware estándar del NXT. Este software está disponible en código abierto. NXC: NXC es un lenguaje de alto nivel similar a C. Utiliza el firmware original de LEGO y está disponible para Windows, Mac OSX y Linux (ia32). Ha sido desarrollado por John Hansen. Hay disponible una guía del programador y un tutorial en ingles (http://bricxcc.sourceforge.net/nbc) y se puede utilizar como editor BricxCC. En la siguiente tabla podemos ver cuales son los principales entornos de desarrollo disponibles para implementar nuestras aplicaciones y las características que poseen cada uno de ellos.

- 43. 43 Tabla 1: Comparación de lenguajes de programación

- 44. 44 3.- DESARROLLO TEÓRICO II: TECNOLOGÍA AGENTE 3.1. Historia Nwana (1996) prefiere separar la investigación de la tecnología agente en dos hilos principales, el primero de ellos se situaría sobre 1977, mientras que el segundo y último lo haría alrededor de 1990. La primera línea de investigación tiene sus raíces en la inteligencia artificial distribuida (DAI), dando lugar a que el concepto de agente aparezca en los primeros estudios sobre inteligencia artificial en la década de los 70. De hecho, surge en el momento en el que Carl Hewitt define el modelo de Actor (1977). En este modelo, Hewitt propone el concepto de objeto auto-contenido, interactivo y concurrente. Además, dicho objeto encapsula estados internos y puede responder a mensajes de otros objetos similares. “Is a computational agent which has a mail address and a behaviour. Actor communicate by message-passin and carry out theis actions concurrently” (Hweitt, 1977, p. 131). En esta primera línea de investigación, el trabajo de los investigadores estaba concentrado en resolver grandes cuestiones básicas, tales como la interacción y la comunicación entre los agentes, la descomposición y distribución de tareas, la coordinación y cooperación, la resolución de conflictos mediante negociación, etc. Su objetivo era especificar, analizar, diseñar e integrar sistemas que comprendían la colaboración de múltiples agentes. Este trabajo se caracterizo también por investigar el desarrollo teórico, arquitectónico y de aspectos del lenguaje. Sin embargo, desde 1990, y contrastando con la anterior, surge la actual línea de investigación, la cual es más reciente y está en constante movimiento, estudiando un rango mas amplio de tipos de agentes. La gran diversidad de aplicaciones e investigaciones son solo una demostración de que los agentes software se están convirtiendo en una corriente principal. 3.2. ¿Qué es un agente software? Actualmente se está produciendo un gran uso de la palabra agente sin tener un pleno conocimiento de lo que ello significa. Algunos programas son llamados agentes simplemente porque son capaces de planificarse para la consecución de un objetivo o tarea en una maquina remota; algunos porque logran controlar tareas de bajo nivel mientras utilizan lenguajes de programación de alto nivel; algunos porque son una abstracción o encapsulación de fuentes de información o servicios; otros porque

- 45. 45 implementan funciones cognitivas, o porque tienen funciones parecidas a la inteligencia distribuida, etc. El término agente describe una abstracción de software, una idea o concepto, similar a los métodos, funciones y objetos en la programación orientada a objetos. El concepto de un agente provee una forma conveniente y poderosa de describir una compleja entidad de software, que es capaz de actuar con cierto grado de autonomía, para cumplir tareas en representación de personas. Sin embargo, y a diferencia de los objetos (que son definidos por métodos y atributos), un agente es definido por su propio comportamiento. Los agentes software surgen dentro de la Inteligencia Artificial y, a partir de los trabajos desarrollados en el área de la Inteligencia Artificial Distribuida (DAI), surge el concepto de sistemas multiagente. Podemos encontrar otra definición de agente software mucho mas especifica y que seguramente los investigadores de esta tecnología encuentran mas aceptable: Un agente software es una entidad la cual funciona continua y autónomamente en un entorno particular, a menudo inhabitado por otros agentes o procesos. La necesidad de continuidad y autonomía deriva de nuestra necesidad de que un agente sea capaz de llevar a cabo actividades de forma flexible e inteligente como respuesta de los cambios del entorno, pero sin la intervención de un humano. Idealmente, un agente que funciona continuamente en un entorno por un largo periodo de tiempo, debe ser capaz de aprender de esta experiencia. Además, se busca que un agente habite en un determinado ambiente con otros agentes y tenga las habilidades necesarias para comunicarse y cooperar entre ellos, moviéndose de un lado a otro como consecuencia de ello. El termino agente software engloba a una gran cantidad de tipos de agentes, mucho más específicos y concretos. Coherente con los requerimientos de un problema en particular, cada agente puede poseer un mayor o menos grado de atributos. Dichos atributos. Franklin y Graesser (1997) discutieron sobre estos atributos clave que definen a cualquier agente, los cuales son: Persistencia: el código no es ejecutado bajo demanda sino que se ejecuta continuamente y decide por si mismo cuando debería llevar a cabo alguna actividad. Autonomía: pueden trabajar sin intervención directa del usuario y tienen cierto control sobre sus acciones y estado interno. Los agentes tienen la capacidad de seleccionar tareas, priorizarlas, tomar decisiones sin intervención humana, etc.

- 46. 46 Capacidad o habilidad social: tienen la habilidad de sincronizarse con personar y otros agentes, a través de coordinación y comunicación, para colaborar en la consecución de una determinada tarea. Reactividad: pueden percibir su entorno (que puede ser el mundo físico, un usuario detrás de una interfaz gráfica o vocal, aplicaciones en la red, u otros agentes) y responder oportunamente a cambios que se produzcan en el mismo. Iniciativa: el comportamiento de los agentes esta determinado por los objetivos (metas) que persiguen y por tanto pueden producir acciones no sólo como respuesta al entorno. Continuidad temporal: persistencia de su identidad y estado durante largos periodos de tiempo. Adaptabilidad: deben ser capaces de aprender e improvisar a partir de su experiencia. Movilidad: deben ser capaces de desplazarse de una posición a otra de forma autodirigida. Figura 37: Relación entre el agente y el entorno Es bastante común no comprender qué es y qué no es un agente. Por esto, debemos aclarar que un agente no es:

- 47. 47 a) Un programa o un método. La principal diferencia la encontramos en cuatro de las cualidades que hemos descrito anteriormente: reactividad, autonomía, persistencia y búsqueda de objetivos. b) Un objeto. Los agentes son entidades mucho más autónomas que los objetos, ya que tienen comportamientos flexibles, reactivos, proactivos y sociales. Además, un agente tiene al menos un hilo de ejecución que se encarga del control, aunque puede tener incluso más. c) Un sistema experto. Los sistemas expertos no están acoplados a su entorno, además de no tener designado ningún comportamiento de tipo reactivo o proactivo, además de no poseer habilidades sociales. 3.3. Tipos de agentes Nwana propone, en 1996, una tipología de agentes que identifica otras dimensiones de clasificación, con lo que clasifica a los agentes acorde a: Movilidad: estático o móvil. Presencia de un modelo de razonamiento simbólico: deliberativo o reactivo. Exhibición de atributos ideales y primarios: Autonomía, cooperación, aprendizaje. Para estas características, Nwana deriva cuatro tipos de agentes: colaborativos, colaborativo con aprendizaje, interface y smart. Roles: información o Internet. Filosofías hibridas: si combina dos o mas enfoques en un agente concreto. Atributos secundarios: versatibilidad, benevolencia, veracidad, integridad, continuidad temporal, cualidades emocionales, etc. Después de desarrollar esta tipología, Nwana describe las investigaciones en curso en siete categorías: 1. Collaborative agentes 2. Interface agentes 3. Mobile agentes 4. Information/Internet agentes 5. Reactive agentes

- 48. 48 6. Hybrid agentes 7. Smart agentes Figura 38: Tipos de agentes por Nwana Por su parte, y después de las definiciones dadas por Nwana, Franklin y Graesser, en 1996, dan la suya propia: “un agente autónomo es un sistema situado dentro de una parte del entorno que sensoriza, actuando sobre el todo el tiempo, buscando en todo momento cumplir con sus objetivos.” Al observar que, después de esta definición, incluso un termómetro podría ser considerado un agente, discuten una nueva clasificación, sugiriendo que los agentes pueden ser categorizados por estructuras de control, entornos (bases de datos, sistemas de ficheros, Internet), por el leguaje en el que han sido escritos, y sus aplicaciones. Por eso, finalmente definen la taxonomía que podemos ver en la siguiente imagen.

- 49. 49 Figura 39: Tipos de agentes por Franklin y Graesser El tiempo y la experiencia acabaran determinando cual es el largo significado de la palabra agente. Como muchos otros términos en uso común como “desktop”y “mouse”, la palabra agente terminará denotando un artefacto software en concreto. 3.4. ¿Por qué agentes? El trabajo original en agentes instigado por investigadores trata de estudiar modelos computacionales de inteligencia distribuida. En el diseño de sistemas distribuidos los agentes proporcionan aspectos sociales, lenguajes y protocolos de comunicación de agentes y distribución de datos, control, conocimiento y recursos. En cuanto al análisis del sistema, un sistema multi-agente tiene un mayor grado de abstracción que un sistema programado mediante la utilización de objetos. Al utilizar la tecnología agente, nuestra aplicación tiene una mayor autonomía y capacidad de decisión, componentes heterogéneos que mantienen relaciones entre ellos y con escalas de tiempo diferentes. Además, facilitan la evolución del sistema, ya que son capaces de adaptarse al entorno y las modificaciones que éste va realizando. Proporcionan escalabilidad, pudiendo añadir más agentes si es necesario llevar a cabo acciones con una mayor carga de trabajo. Podemos también añadir funcionalidad en tiempo de ejecución, con un desarrollo incremental, con capacidad de aceptar nuevos elementos.

- 50. 50 Los principales motivos que nos han llevado a seleccionar a los agentes son la autonomía de decisión, punto muy importante en nuestro caso en concreto, en el que queremos distribuir una serie de robots para que realicen movimientos de forma colaborativa. También son ventajas el flujo de control propio, la encapsulación de la activación de un comportamiento, la autonomía y la organización mediante las relaciones sociales entre los agentes. Sin embargo, los agentes puede que no siempre sean la solución ideal para un determinado caso de estudio. La tecnología agente, debido a su autonomía y flexibilidad, puede acarrear una ausencia de control/visión global del sistema, lo que puede no ser beneficioso en determinados escenarios. 3.5. Comunicación entre agentes 3.5.1. Introducción Comunicar, según la Real Academia Española, consiste en “hacer a otro partícipe de lo que uno tiene”. La comunicación es uno de los actos más importantes en un sistema multiagente, ya que es la llave para obtener todo el potencial de dicho paradigma. Los sistemas multiagente, al estar orientados a la resolución distribuida de problemas, necesitan de la capacidad de comunicación mediante la cual establecer estrategias de cooperación. Los modelos de comunicación se dividen en dos grandes grupos. Arquitectura de pizarra: La pizarra es una zona de trabajo común donde se encuentra la información a compartir. Esta pizarra puede ser consultada por todos los agentes, del mismo modo que todos pueden dejar información en ella. Pueden existir agentes con tareas de control específicas sobre la pizarra, así como varias pizarras. De este modo, no hay comunicación directa entre los agentes, teniendo toda la información centralizada en cada una de las pizarras.

- 51. 51 Figura 40: Comunicación utilizando una pizarra Paso de mensajes: La comunicación se realiza del mismo modo que se realiza entre dos seres humanos, mediante el establecimiento e intercambio directo de mensajes entre dos agentes (emisor y receptor). Como ventaja encontramos que es más flexible que la anterior, además de que no es necesario tener toda la información centralizada. Figura 41: Comunicación utilizando mensajes 3.5.2. Organizaciones de estandarización Las organizaciones de estandarización se encargan de la redacción y aprobación de las normas que rigen cual debe ser el formato de la información. En concreto, podemos hablar de tres organizaciones de estandarización para el caso de los agentes software. 3.5.2.1. OMG Asociación de empresas e instituciones formada a finales de los 80. Su objetivo era la reutilización, portabilidad e interoperabilidad de sistemas distribuidos de componentes software orientados a objetos. Sus resultados fueron UML (Unified

- 52. 52 Modeling Languaje), CORBA (Common Object Requies Broker Architecture) y MASIF (Mobile Agent System Interoperability Facility). 3.5.2.2. KSE La iniciativa fue tomada por varias empresas a las cuales interesaba el software agente: ARPA (Advanced Research Projects Agency), ASOFR (Air Force Office of Scientific Research), NRI (Corporation for National Research Initiative) y NSF (National Science Foundation). Su objetivo principal fue facilitar la compartición y reutilización de bases y sistemas basados en conocimiento. Además, para conseguir una interacción eficaz de agentes software eran necesarias tres componentes fundamentales: 1. Un leguaje común 2. Una comprensión común del conocimiento intercambiado 3. Una habilidad para intercambiar todo lo relativo al lenguaje y la comunicación. De sus trabajos surgen varios lenguajes como resultado, los cuales son: KIF (Knowledge Interchange Format): lenguaje para el intercambio de conocimiento. Ontolingua: Lenguaje para la definición de ontologías KQML (Knowledge Query and Manipulation Language): Lenguaje para la comunicación entre agentes e interoperabilidad entre agentes en un entorno distribuido. 3.5.2.3. FIPA Organización internacional dedicada a la promoción de la industria de los agentes inteligentes mediante el desarrollo de especificaciones que soporten la interoperabilidad entre agentes y aplicaciones basadas en agentes. Su especificación cubre todos los aspectos de un entorno de agentes: aplicaciones, arquitectura, comunicación, protocolos de interacción, actos comunicativos, lenguajes de contenidos, gestión de agentes y transporte de mensajes. Hasta la fecha ha publicado 3 conjuntos de especificaciones: FIPA 97, FIPA 98 y FIPA 2000.

- 53. 53 3.6. FIPA (Foundation for Intelligent Physical Agents) Una de las formas de alcanzar la deseada interoperabilidad entre plataformas es la definición y uso de estándares aprobados por un comité internacional. En el área de los agentes, FIPA es la organización encargada de producir especificaciones para la interacción de agentes y sistemas de agentes heterogéneos. En la siguiente sección describiremos brevemente el modelo de referencia propuesto por FIPA para las plataformas de agentes, así como el formato e intercambio de los mensajes. 3.6.1. Modelo de referencia de FIPA Uno de los objetivos principales de FIPA es especificar una arquitectura de agentes que permita la utilización de un amplio número de mecanismos y servicios, como varios protocolos de transporte o servicios de directorio. Dada la posibilidad elegir entre varios de estos mecanismos y protocolos, los sistemas de agentes construidos de acuerdo a esta arquitectura deberían de ser capaces de interoperar a través de pasarelas de transporte, ya que la especificación para una arquitectura abstracta de FIPA permite la creación de diferentes implementaciones y ofrece también las transformaciones tanto para transporte de mensajes, esquemas de codificación de mensajes y localización de agentes y servicios a través de directorios de servicios. Sin embargo FIPA no cubre otros aspectos que surgen o dependen de la implementación, bien por que están fuera de ámbito o porque no están incluidos en las especificaciones. Una plataforma de agentes FIPA se define como el software que implementa un conjunto de especificaciones FIPA. Para que se considere que sigue las normas de FIPA, una plataforma debe implementar al menos la especificación sobre la gestión de agentes y las relativas al lenguaje de comunicación de agentes (ACL). La primera se ocupa del control y gestión de agentes dentro de y a través de plataformas de agentes. Las relativas al ACL se encargan del formato de los mensajes, los protocolos de interacción y de intercambio de mensajes entre agentes, la descripción de actos comunicativos que definen la semántica de los mensajes intercambiados y los diferentes lenguajes para expresar el contenido de un mensaje (lenguaje de contenido).

- 54. 54 Figura 42: Intercambio de mensajes en FIPA El objetivo de la especificación de gestión de agentes es ofrecer un marco de trabajo estándar donde los agentes FIPA existan y operen, estableciendo un modelo de referencia lógico para la creación, registro, localización, comunicación, migración y baja de agentes. Este modelo de referencia se compone de un conjunto de entidades que ofrecen diferentes servicios. Estas entidades son: Agente: un agente software es un proceso computacional que implementa la funcionalidad autónoma y comunicativa de la aplicación, ofreciendo al menos un servicio. Los agentes se comunican a través de un ACL. Un agente debe tener al menos un propietario y un identificador de agente (AID) que lo identifica de forma unívoca. Además, un agente puede disponer de varias direcciones de transporte a través de las cuales puede ser contactado. Dependiendo de la implementación de la plataforma un agente puede tratarse de un componente Java o un objeto CORBA. DF (Directory Facilitator): un facilitador de directorio que ofrece un servicio de páginas amarillas para localizar agentes. Los agentes deben registrarse previamente en este servicio para ser localizados como proveedores de un servicio, y recurren a él en busca de agentes que ofrezcan un determinado servicio.

- 55. 55 AMS (Agent Management System): un sistema de gestión de agentes que controla el acceso y uso de la plataforma de agentes. Sólo puede existir un agente AMS por plataforma, y se encarga de generar AIDs válidos además de ofrecer un servicio de búsqueda de agentes por nombre. MTS (Message Transport Service): un servicio de transporte de mensajes ofrece un servicio de comunicación entre agentes, encargándose del transporte de mensajes entre agentes. FIPA especifica para este componente un modelo de referencia y varias especificaciones sobre distintos protocolos y mecanismos de transporte que favorece la interoperabilidad entre plataformas. AP (Agent Platform): la plataforma de agentes ofrece una infraestructura física sobre la que desplegar los agentes y está compuesta de un software de soporte, los componentes para la gestión de agentes (DF, AMS, y MTS) y los agentes. Además, FIPA también define y especifica una serie de elementos y conceptos importantes necesarios para conseguir la interoperabilidad. Estos conceptos son: un servicio (para definir un conjunto de acciones incluidas en una ontología), un ACL (lenguaje para construir mensajes y actos comunicativos) y un AID (identifica un agente incluyendo denominaciones, roles y direcciones). 3.6.2. Comunicación FIPA – FIPA ACL La comunicación con FIPA ACL es un servicio de transporte utilizado por los agentes que implementan la especificación FIPA, con el fin de intercambiar información entre ellos. Está basado en la teoría de los actos del habla y con él somos capaces de enviar un mensaje, codificarlo y transmitirlo como una secuencia de bytes. Un mensaje en FIPA ACL representa la intención de realizar alguna acción (acto comunicativo). Este servicio tiene las siguientes características: 1. Servicio de confianza, donde los mensajes que están bien creados/formados no tienen inconveniente para llegar a su destino. 2. Fiable, ya que los mensajes se reciben tal y como se envían, sin modificaciones. 3. Ordenado. El orden de llegada de los mensajes es el mismo que el orden de salida. El elemento básico para la comunicación en la especificación FIPA ACL es el mensaje. Estos mensajes tienen la siguiente estructura: 1. Identificador del acto comunicativo (obligatorio).

- 56. 56 Figura 43: Actos comunicativos en FIPA 2. Pares parámetro-valor sin un orden predefinido (opcionales). Los posibles parámetros a definir en un mensaje ACL son: a. Content: Contenido del mensaje. b. Sender: Identidad del emisor del mensaje. c. Receiver: Identidad del receptor del mensaje, puede ser un agente o una lista de agentes. d. Language: El nombre del lenguaje de representación empleado en el atributo content. e. Ontology: El nombre de la ontología utilizada en el atributo content. f. Reply-With: Etiqueta para la respuesta (si es que el emisor la espera). g. In-Reply-To: Etiqueta esperada en la respuesta. h. Protocol: identificador del protocolo de interacción que se está utilizando. i. Conversation-Id: identificador de una secuencia de actos comunicativos que forman parte de una misma conversación.

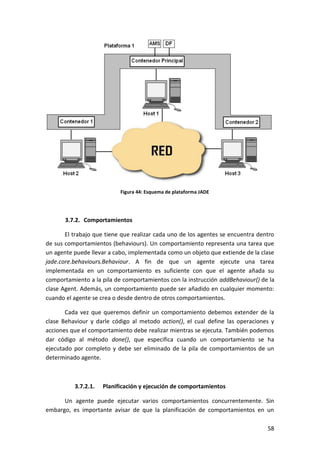

- 57. 57 j. Reply-To: Agente al que han de ser enviadas las respuestas (si no es el emisor). k. Reply-By: Indicación del tiempo en el que se quiere que se responda al mensaje. Además, el modelo de comunicación está basado en la asunción de que dos agente que quieren conversar han de compartir una ontología común que describa el universo del discurso, de forma que podamos asegurar que estos agentes atribuyan el mismo significado a los símbolos utilizados en los mensajes. Una ontología es una descripción formal de los conceptos y relaciones que pueden existir en una determinada comunidad de agentes. 3.7. JADE (Java Agent DEvelopment Framework) Java Agent DEvelopment Framework, o JADE, es una plataforma software para el desarrollo de agentes, implementada en JAVA, que ha estado en desarrollo al menos desde 2001. La plataforma JADE soporta la coordinación de múltiples agentes FIPA y proporciona una implementación estándar del lenguaje de comunicación FIPA-ACL. Jade fue desarrollado originalmente por Telecom Italia y se distribuye como software libre. Podemos descargar su última versión desde su sitio (http://jade.tilab.com) 3.7.1. La plataforma de agentes JADE La plataforma JADE es 100% compatible con el JDK 1.4 o superiores, e incluye la funcionalidad necesaria para la creación básica de agentes, la programación de comportamiento de los agentes en base a Behaviours, implementación de la especificación FIPA ACL para el envío y recepción de mensajes, clases útiles para programación de protocolos FIPA, manejo de información usando ontologías, etc. Además, proporciona la plataforma FIPA (AMS, Facilitador de directorio y MTS), puede ejecutarse en una o varias JVM (donde cada JVM es vista como un entorno en donde los agentes pueden ejecutarse concurrentemente e intercambiar mensajes) y se organiza en contenedores (un contenedor principal que contiene el AMS, DF y RMA y más contenedores no principales conectados al principal).

- 58. 58 Figura 44: Esquema de plataforma JADE 3.7.2. Comportamientos El trabajo que tiene que realizar cada uno de los agentes se encuentra dentro de sus comportamientos (behaviours). Un comportamiento representa una tarea que un agente puede llevar a cabo, implementada como un objeto que extiende de la clase jade.core.behaviours.Behaviour. A fin de que un agente ejecute una tarea implementada en un comportamiento es suficiente con que el agente añada su comportamiento a la pila de comportamientos con la instrucción addBehaviour() de la clase Agent. Además, un comportamiento puede ser añadido en cualquier momento: cuando el agente se crea o desde dentro de otros comportamientos. Cada vez que queremos definir un comportamiento debemos extender de la clase Behaviour y darle código al metodo action(), el cual define las operaciones y acciones que el comportamiento debe realizar mientras se ejecuta. También podemos dar código al método done(), que especifica cuando un comportamiento se ha ejecutado por completo y debe ser eliminado de la pila de comportamientos de un determinado agente. 3.7.2.1. Planificación y ejecución de comportamientos Un agente puede ejecutar varios comportamientos concurrentemente. Sin embargo, es importante avisar de que la planificación de comportamientos en un